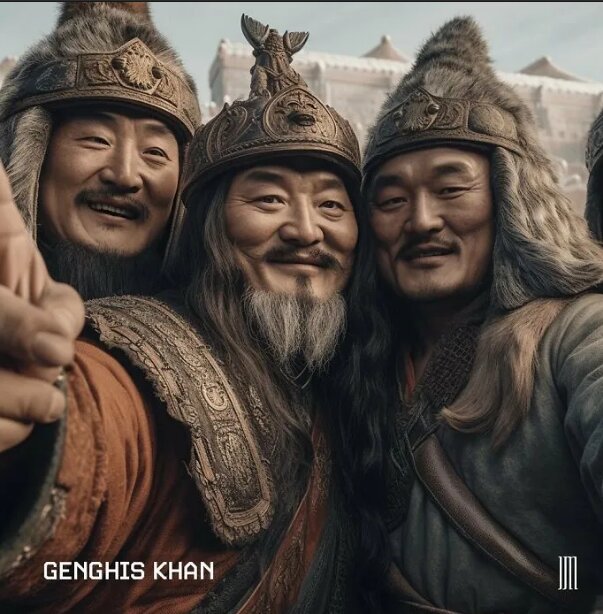

این تصویر جنجالی واقعی است یا فیک؟

سیستم تولید تصویر با هوش مصنوعی، تشخیص عکسهای جعلی را آنقدر سخت کرده که برای تشخیص واقعی بودن آنها به یک هوش مصنوعی دیگر نیاز داریم!

خبرآنلاین: سیستم تولید تصویر با هوش مصنوعی، تشخیص عکسهای جعلی را آنقدر سخت کرده که برای تشخیص واقعی بودن آنها به یک هوش مصنوعی دیگر نیاز داریم!

شاید به تازگی عکسهایی دیده باشید که شما را شگفتزده کرده باشند؛ عکسهایی مثل بازداشت دونالد ترامپ، رئیسجمهور سابق آمریکا و یا پاپ که یک کت سفید براق به تن کرده است، که همه آنها فیک و جعلی بودهاند. تمام این عکسهای وایرال شده، محصول سیستمهای هوش مصنوعی بودند که از روی متنی که کاربران وارد سیستم کردهاند، ساخته شدهاند. این برنامهها به اندازهای پیشرفت کردهاند که میتوانند همه را قانع کرده و فریب دهند.

پس چطور یک بیننده شکاک و دیرباور میتواند اصالت تصاویری را که شاید توسط یک سیستم هوش مصنوعی مانند DALL-E، Midjourney یا Stable Diffusion تولید شده را تشخیص دهد؟

هر سیستم تولید تصویر با هوش مصنوعی و هر عکس تولید شده توسط این سیستمهای مختلف، در میزان متقاعدکننده بودن و یا اینکه چه علائمی ممکن است الگوریتم آنها را از بین ببرد متفاوت است. به عنوان مثال، سیستمهای هوش مصنوعی در طول تاریخ تلاش کردهاند تا حرکت دستهای انسان را تقلید کنند و همیشه ناموفق بودهاند.

با این حال، با پیشرفت فناوری، به نظر میرسد سیستمهایی مانند Midjourney V۵ (هوش مصنوعی Midjourney که برای تبدیل متن به عکس استفاده میشود) این مشکل را حداقل در برخی از سیستمها برطرف کرده. در کل کارشناسان میگویند که تشخیص بهترین تصاویر از بهترین مولدها سخت است اما غیرممکن نیست.

شیام ساندار(Shyam Sundar)، یکی از محققان دانشگاه ایالتی پنسیلوانیا که درباره تأثیرات روانی فناوریهای رسانهای مطالعه میکند، میگوید: « اینکه مولدین تصاویر با هوش مصنوعی، قادر به انجام چه کارهایی هستند، بسیار شگفتانگیز است. در یک سال اخیر شاهد جهش و افزایش تولید تصاویر جعلی بودهایم.»

ساندار از برخی از عوامل موثر در این جهش نام برده که عبارتند از: افزایش تعداد تصاویر موجود که برای آموزش چنین سیستمهای هوش مصنوعی استفاده میشوند و همچنین پیشرفت در زیرساختهای پردازش دادهها و قابل دسترس بودن این فناوری برای کاربران عادی اینترنت. به گفته او این عوامل منتهی به تولید تصاویری میشوند که بهصورت مصنوعی تولید شدهاند و همه جا هستند و تشخیص آنها تقریباً غیرممکن است.

یکی از آزمایشهای اخیر نشان داد که هوش مصنوعی چقدر میتواند فریب دهنده باشد. سوفی نایتینگل، روانشناس دانشگاه لنکستر انگلیس که بر فناوری دیجیتال تمرکز دارد، در آزمایشی با حضور داوطلبان آنلاین از آنان خواست تا عکسهای گذرنامه ایجاد شده توسط یک سیستم هوش مصنوعی به نام StyleGAN۲ و تصاویر واقعی را از هم تشخیص دهند.

محققان این آزمایش را در سال ۲۰۲۱ انجام دادند و نتایج آن بسیار ناامیدکننده بود. نایتینگل میگوید: «به طور متوسط، عملکرد و انتخاب مردم تقریباً شانسی بود و اساساً، ما در نقطهای هستیم که آنقدر همه چیز واقعی به نظر میرسد که مردم نمیتوانند به طور قطعی تفاوت بین تصاویر مصنوعی و واقعی را تشخیص دهند.»

به گفته او هر چند انسانها برای توسعه هوش مصنوعی در جهت مثبت، کمکهایی کردهاند؛ اما اگر کسی برای اهداف پلید خود به دنبال استفاده از چنین برنامههایی باشد، احتمالا موفق خواهد شد.

در آزمایش دوم، محققان سعی کردند به افراد تحت آزمایش کمک کنند تا تواناییهای تشخیص تصاویر ساخته شده توسط هوش مصنوعی خود را بهبود ببخشند. آنها از قبل به شرکتکنندگان نکاتی را برای تشخیص تصاویر تولیدی توسط هوش مصنوعی تعلیم دادند و پس از پاسخگویی، جوابها چه درست و یا غلط، علامتگذاری کردند.

در این توصیهها و آموزشها، قسمتهایی را که الگوریتمهای هوش مصنوعی اغلب در آن دچار مشکل میشوند برجسته شده بود؛ بخشهایی نظیر گوشوارههای نامتقارن در فرد و یا تار بودن دندانها در تصاویر ساخته شده. نایتینگل همچنین خاطرنشان میکند که الگوریتمها اغلب برای ایجاد چیزی پیچیدهتر از یک پس زمینه ساده تلاش میکنند. او میگوید:« حتی با وجود این همه توصیه و تعلیم، دقت شرکتکنندگان برای تشخیص عکسهای مصنوعی تنها حدود ۱۰درصد افزایش پیدا کرد، در حالیکه سیستم هوش مصنوعی از آن زمان تاکنون بسیار پیشرفت کرده و ارتقاء یافتهاند.»

از قضا، همانطور که فناوری تولید تصاویر مصنوعی همچنان در حال پیشرفت است، بهترین وسیله دفاعی انسانها برای جلوگیری از فریب خوردن توسط یک سیستم هوش مصنوعی، داشتن یک سیستم هوش مصنوعی دیگر است: سیستمی که برای تشخیص تصاویر مصنوعی آموزش دیده شده. کارشناسان میگویند که با پیشرفت تولید تصاویر هوش مصنوعی، الگوریتمهای جدیدی که برای شناسایی آنها تولید شده، مجهزتر از انسانها هستند و میتوانند در مقیاس پیکسلی عمل کرده و تصاویر فیک و جعلی را تشخیص دهند.

یونگ جائهلی، دانشمند علوم کامپیوتر در دانشگاه ویسکانسین مدیسون، بر این باور است که برنامههای پویشی هوش مصنوعی همانند ماشین یادگیری، چند وظیفهای عمل میکنند. لی میگوید: « ابتدا باید مجموعهای از دادههای تصاویر واقعی را با مجموعهای از دادههای تصاویر تولید شده توسط هوش مصنوعی جمعآوری کنید. سپس میتوانید یک مدل یادگیری ماشینی برای تشخیص این دو، آموزش دهید.»

با این حال لی و دیگر کارشناسان میگویند که این سیستمها دارای کاستیهای قابل توجهی هم هستند. اکثر چنین الگوریتمهایی بر روی تصاویر یک سیستم هوش مصنوعی خاص آموزش داده میشوند که قادر به شناسایی تصاویر جعلی تولید شده توسط الگوریتمهای دیگر نخواهند بود. (به گفته لی، او و یک تیم تحقیقاتی در حال کار بر روی راهی برای جلوگیری از این مشکل هستند. آنها قصد دارند تا با آموزش تشخیص این تصاویر تعیین کنند که چه چیزی یک تصویر را واقعی می کند). اکثر آشکارسازها فاقد رابط کاربری آسان هستند و این باعث میشود افراد زیادی وسوسه شوند تا سیستمهای هوش مصنوعی مولد را امتحان کنند.

علاوه بر این، آشکارسازهای هوش مصنوعی ، همیشه با مولدین تصویرهوش مصنوعی در رقابت هستند، که برخی از آنها الگوریتمهای تشخیص مشابهی را در خود جای دادهاند، که از آنها به عنوان راهی برای یادگیری نحوه کاهش خروجی تصاویر جعلی استفاده میکنند.

وائل عبدالمجید، دانشیار پژوهشی علوم کامپیوتر در دانشگاه کالیفرنیای جنوبی میگوید: «نبرد بین سیستمهای هوش مصنوعی که تصویر تولید میکنند و سیستمهای هوش مصنوعی که تصاویر تولید شده توسط هوش مصنوعی را تشخیص میدهند، یک مسابقه تسلیحاتی خواهد بود. من فکر نمیکنم که هیچ یک از طرفین به این زودی برنده شود.»

وائل عبدالمجید میگوید که هیچ وقت نمیتوان جلوی تصاویر تولید شده توسط هوش مصنوعی را گرفت، اما این بدان معنا نیست که ما باید تسلیم شویم. او پیشنهاد میکند که این وظیفه پلتفرمهای رسانههای اجتماعی است که شروع به مقابله با محتوای تولید شده توسط هوش مصنوعی در سایتهای خود کنند، زیرا این شرکتها الگوریتمهای تشخیص بهتری نسبت به کاربران عادی دارند.

کاربران باید با شک و تردید بیشتری اطلاعات بصری را بررسی کرده و قبل از به اشتراکگذاری آنها در پلتفرمهای اجتماعی، مطمئن باشند که این تصاویر تولید هوش مصنوعی نباشند. او میگوید:«ما با این فکر بزرگ میشویم که دیدن، باور کردن است. اما این عبارت دیگر درست نیست. دیدن دیگر مساوی با باور نکردن نیست.»

ارسال نظر